Sommario:

- Autore John Day day@howwhatproduce.com.

- Public 2024-01-30 10:01.

- Ultima modifica 2025-01-23 14:49.

Stanco dei tuoi dispositivi "intelligenti" che ti origliano? Allora questo toolkit per hackerare la sorveglianza fa per te!

HacKIT è un kit hard (wear) per la privacy civica di bassa e alta tecnologia per la riprogettazione, l'hacking e il recupero di Amazon Echo, Google Home e Apple Siri. I dispositivi vocali sono dotati di "indossabili" stampati in 3D e di un circuito che genera suoni che offuscano e confondono gli algoritmi di riconoscimento vocale.

Usa il design speculativo come una forma di resistenza civica per autorizzare i produttori di tutto il mondo a sovvertire l'egemonia del capitalismo di sorveglianza. Mette un punto esclamativo sulla sorveglianza ed espone fino a che punto siamo stati superati in astuzia dai nostri dispositivi "intelligenti".

La mia speranza è che questo sia un toolkit per creare/creare/inventare in modo critico tecnologie e futuri incentrati sull'umanità. Divertiti!

Forniture

Scarica i modelli CAD per i "indossabili" stampati in 3D e i campioni audio qui.

Passaggio 1: (Metodo #1) Hack tattile

HacKIT viene fornito con 3 metodi di hacking per soddisfare una vasta gamma di produttori. L'hacking tattile è un metodo da basso a non tecnologico per disattivare e silenziare Alexa.

Materiali: argilla morbida, schiuma di gomma, tessuto di rame

Come usare: come mostrato nelle immagini sopra, usa i materiali per coprire i microfoni dei tuoi dispositivi vocali

Risultati: la registrazione vocale è attutita e disattivata

Passaggio 2: (Metodo #2) Hack algoritmico

Questo hack mira ad alimentare gli algoritmi di riconoscimento vocale di Alexa, Google e Siri con dati falsi per interrompere le loro capacità di creare un profilo utente mirato. I loop audio vengono riprodotti a ripetizione attivando il riconoscimento di dati falsi. Alcuni campioni audio includono rumore bianco xx

Materiali: Adafruit Audio FX soundboard (16 MB), 2 altoparlanti in miniatura, batteria lipo e caricabatterie, interruttore, file audio, "indossabili" stampati in 3D

Come usare:

Passaggio 1: scarica i file audio e trasferiscili sulla tavola armonica

Passaggio 2: scarica i file CAD e i "wearables" stampati in 3D

Passaggio 3: saldare gli altoparlanti, la porta di ricarica della batteria e passare alla tavola armonica

Passaggio 4: assembla il circuito con i dispositivi indossabili 3D e il gioco è fatto!

Risultati: gli algoritmi di riconoscimento vocale non possono sviluppare con precisione il tuo profilo utente, proteggendo la tua identità e privacy

Passaggio 3: (Metodo n. 3) Hack di offuscamento

Il metodo n. 3 offre ai produttori una maggiore flessibilità nella specificità del loro hack. Mentre Algorithmic Hack riproduce loop sonori udibili, l'offuscamento hack consente l'uso di frequenze ultrasoniche al di sopra della gamma dell'udito umano per offuscare le registrazioni audio di Alexa, Google e Siri. Per questo, ho incluso un PCB che ho progettato e costruito. I creatori possono anche sfruttare il lavoro di Bjorn per personalizzare le parole di attivazione e ridurre i falsi trigger. Project Alias consente inoltre agli utenti di disattivare il rumore bianco con le parole di attivazione.

Materiali: PCB per frequenze ultrasoniche, ATtiny45, 2 amplificatori audio in classe D, Raspberry Pi (opzionale), 2 altoparlanti miniaturizzati, batteria lipo e caricabatterie, interruttore, "indossabili" stampati in 3D, codice Arduino per programmare ATtiny45

Modalità d'uso (frequenza ultrasonica):

Passaggio 1: scarica il file Eagle PCB e invialo per la fabbricazione

Passaggio 2: scarica il codice Arduino e programma ATtiny45

Passaggio 3: scarica i file CAD e i "wearables" stampati in 3D

Passaggio 4: saldare gli altoparlanti, la porta di ricarica della batteria e passare al PCB

Passaggio 5: assembla il circuito con i dispositivi indossabili 3D e il gioco è fatto!

Come usare (Project Alias): fare riferimento alla documentazione di Bjorn qui

Risultati: i microfoni di Amazon Echo e Google Home sono offuscati da frequenze ultrasoniche/rumore bianco che impediscono qualsiasi registrazione vocale ingiustificata quando un utente non sta utilizzando attivamente il proprio dispositivo. Fornisce agli utenti sia la funzionalità pratica di un assistente vocale proteggendo anche la privacy dell'utente!

Passaggio 4: hackera via

Questo progetto è solo uno dei tanti casi per resistere e sovvertire la sorveglianza in un'era di capitalismo della sorveglianza. Designer, produttori e tecnologi hanno un ruolo etico da svolgere nello smantellamento e nell'esposizione della scatola nera della sorveglianza. La mia speranza è che i futuri hacker possano iterare, aggiungere, modificare e costruire su questo lavoro.

“Può il design speculativo assumere un ruolo sociale e possibilmente politico, combinando il poetico, il critico e il progressista applicando un pensiero eccessivamente fantasioso a questioni seriamente su larga scala?” - Speculative Everything: Design, Fiction e Social Dreaming (Dunne e Raby, 2013)

Consigliato:

Hackerare l'Hexbug Spider XL per aggiungere la visione artificiale utilizzando uno smartphone Android: 9 passaggi (con immagini)

Hackerare l'Hexbug Spider XL per aggiungere la visione artificiale utilizzando uno smartphone Android: Sono un grande fan dell'originale Hexbug™ Ragno. Ne ho posseduti più di una dozzina e li ho hackerati tutti. Ogni volta che uno dei miei figli va da un amico’ festa di compleanno, l'amico riceve un Hexbug™ ragno in regalo. Ho hackerato l'o

Come hackerare un sensore di temperatura per una maggiore durata della batteria: 4 passaggi

Come hackerare un sensore di temperatura per una maggiore durata della batteria: Inkbird IBS-TH1 è un ottimo dispositivo per registrare la temperatura e l'umidità per poche ore o giorni. Può essere impostato per registrare ogni secondo fino a ogni 10 minuti e riporta i dati tramite Bluetooth LE a uno smartphone Android o iOS. L'applicazione

Pc-Privacy - Privacy automatizzata Arduino per il tuo computer: 5 passaggi (con immagini)

Pc-Privacy - Privacy automatizzata Arduino per il tuo computer: il problema: se vivi con altre persone o hai il tuo ufficio potresti avere familiarità con il problema delle persone che appaiono casualmente nella tua stanza mentre lavori su dati riservati o semplicemente ne hai alcuni roba strana aperta nella seconda schermata da h

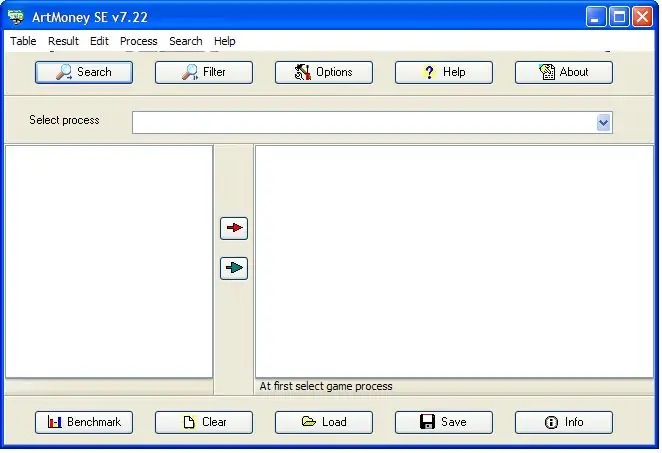

Usare Artmoney per hackerare i giochi: 8 passaggi

Utilizzo di Artmoney per hackerare i giochi: impara come hackerare i giochi utilizzando lo scanner di memoria artmoney in questo tutorial

Vecchio disco rigido Xbox 360 + kit di trasferimento disco rigido = disco rigido USB portatile!: 4 passaggi

Vecchio disco rigido Xbox 360 + kit trasferimento disco rigido = disco rigido USB portatile!: Allora… Hai deciso di acquistare l'HDD da 120 GB per la tua Xbox 360. Ora hai un vecchio disco rigido che probabilmente non userai usare più, così come un cavo inutile. Potresti venderlo o regalarlo… o farne buon uso